在信息爆炸的今天,企業每天都需要處理TB甚至PB級別的海量數據。傳統的數據處理技術在面對如此龐大的數據量時,往往在性能、擴展性和成本上捉襟見肘。此時,以Hadoop為核心的離線批處理技術應運而生,成為了大數據領域不可或缺的基礎架構,并催生了完善的數據處理與存儲支持服務生態。

一、海量數據處理的核心挑戰與離線批處理

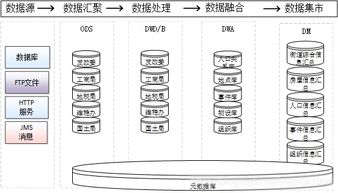

海量數據處理并非單純地“放大”傳統流程,它面臨著三大核心挑戰:數據規模巨大、計算復雜度高、硬件故障成為常態。離線批處理技術正是為應對這些挑戰而設計。其核心理念是“分而治之”:將龐大的數據集分割成多個小塊(分片),分發到大規模廉價服務器集群中進行并行計算,最后匯果。這種模式不要求實時響應,允許在數分鐘到數小時甚至更長時間內完成計算任務,非常適合用于日志分析、數據倉庫ETL、歷史數據挖掘、報表生成等場景。

二、Hadoop:離線批處理的技術基石

Hadoop是一個開源的分布式系統基礎架構,它完美地實現了離線批處理的理念,主要由兩大核心組件構成:

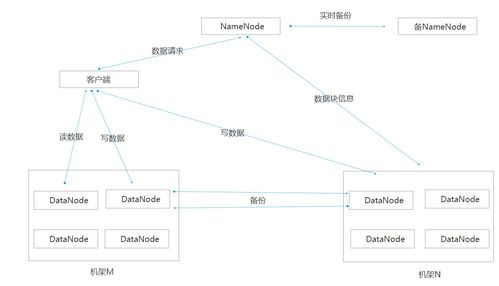

- HDFS(Hadoop Distributed File System):分布式文件系統。它是海量數據存儲的基石。HDFS將文件分割成固定大小的數據塊(默認為128MB),并以多副本(默認為3份)的形式分散存儲在集群的各個節點上。這種設計提供了極高的容錯性(個別節點宕機不影響數據可用性)和吞吐量(支持數據并行讀寫),滿足了海量數據存儲的需求。

- MapReduce:分布式計算框架。它是海量數據計算的引擎。其計算模型分為兩個階段:

- Map(映射)階段:將輸入數據分片,由多個Map任務并行處理,輸出一系列中間鍵值對。

- Reduce(歸約)階段:將Map階段輸出的、擁有相同鍵的中間結果進行匯總、計算,生成最終結果。

這種簡單的模型屏蔽了底層復雜的分布式編程細節(如任務調度、節點通信、容錯處理),使開發者能夠專注于業務邏輯本身。

三、圍繞Hadoop的數據處理與存儲支持服務

單純的Hadoop核心組件如同汽車的引擎和底盤,要使其高效、穩定、易用地運行,還需要一整套支持服務。這些服務構成了現代大數據平臺的關鍵部分:

1. 資源管理與調度服務

- YARN(Yet Another Resource Negotiator):Hadoop 2.0引入的核心組件,它將資源管理與作業調度/監控功能分離。YARN作為一個集群資源管理器,負責統一管理集群的計算資源(CPU、內存),并為上層各種計算框架(如MapReduce、Spark、Flink)提供資源調度服務,使Hadoop從單一的批處理系統演進為一個多任務、多租戶的數據操作系統。

2. 數據集成與處理服務

- Apache Hive:基于Hadoop的數據倉庫工具,它提供了類似SQL的查詢語言(HQL),可以將結構化的數據文件映射為一張數據庫表,并將SQL語句自動轉換為MapReduce或Tez/Spark任務執行,極大降低了數據開發人員的學習和使用門檻。

- Apache Pig:提供了一種高級腳本語言(Pig Latin),用于描述數據流處理過程,同樣會編譯成MapReduce任務執行,適合進行復雜的數據流水線操作。

- Apache Sqoop:用于在Hadoop與結構化數據庫(如MySQL, Oracle)之間高效傳輸批量數據的工具。

- Apache Flume:一個高可用的、高可靠的分布式日志采集、聚合和傳輸系統,常用于將海量日志數據從各個服務器實時攝入HDFS。

3. 數據存儲優化與管理服務

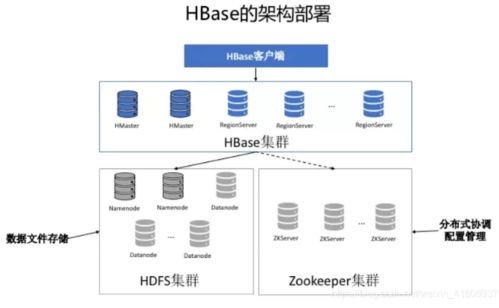

- Apache HBase:構建在HDFS之上的分布式、面向列的NoSQL數據庫。它彌補了HDFS隨機讀寫能力弱的缺點,支持對海量數據的低延遲、隨機訪問,適用于實時查詢場景。

- Apache Parquet / ORC:高效的列式存儲格式。與傳統的行式存儲相比,它們在處理只需要查詢部分列的分析型任務時,能極大減少I/O,提升查詢性能,并支持更好的壓縮。

- Apache ZooKeeper:分布式協調服務,為Hadoop生態中的許多組件(如HBase, Kafka, YARN)提供可靠的分布式鎖、配置維護、命名服務等,是保障集群穩定運行的“潤滑劑”。

四、與展望

以Hadoop為代表的離線批處理技術,通過分布式存儲和計算,從根本上解決了海量數據處理的可行性問題。而圍繞其構建的豐富的數據處理與存儲支持服務生態,則從易用性、效率、功能完備性等方面將這種能力產品化、服務化,使之成為企業數據中臺的堅實底座。盡管如今實時流處理(如Spark Streaming, Flink)和交互式查詢(如Impala, Presto)技術發展迅速,但在處理超大規模歷史數據、運行復雜ETL作業和生成深度分析報表方面,Hadoop離線批處理技術因其成熟度、穩定性和成本優勢,依然占據著不可替代的核心地位。隨著云原生、存算分離等理念的深入,Hadoop生態也在不斷進化,持續為海量數據的價值挖掘提供強大動力。